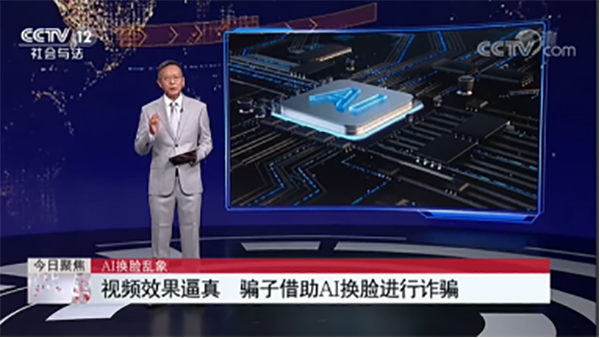

随着科技的不断进步,大家的生活变得更加便利和智能化。技术改变生活,也改变了骗术。这届骗子真的在不该努力的地方格外努力,从声音、图像再到视频,不法分子利用“AI换音换脸”这一技术进行诈骗的案例正在不断增多。

真实案例一

近日,某公司财务小王接到领导电话,要求立刻给供应商转款2万元,并将转账信息以邮件形式发送,转款理由是避免缴纳滞纳金。由于老板的口音十分逼真,小王信以为真,在1小时内转款完成,后发现被骗。

骗子通过骚扰电话录音等来提取某人声音,获取素材后进行声音合成,从而可以用伪造的声音骗过对方。

真实案例二

近日,福州市某科技公司法人代表郭先生接到好友的微信视频联系,对方告诉郭先生,自己的朋友在外地竞标,需要430万元保证金过账。郭先生想都没想就答应了。好友向郭先生要了银行卡号,声称已经把钱转到了郭先生的账户上,还把银行转账底单的截图通过微信发给郭先生。

基于对好友的信任,加上已经视频聊天核实了身份,郭先生没有核实钱款是否到账,就分两笔把430万元转到了好友朋友的银行卡上。

转账成功后,郭先生给好友发了一条微信消息,称事情已经办妥。没想到好友回了一个问号。郭先生拨打好友电话,才知道原来遇上了电信诈骗。骗子通过智能AI换脸和拟声技术,佯装好友对他实施了诈骗。

人脸效果更易取得对方信任,骗子用AI技术换脸,可以伪装成任何人,通过AI技术将他人的脸换成指定人的脸,冒充诈骗对象的亲人、朋友等重要关系人,再加上拟声技术来以假乱真,扰乱诈骗对象的视线进而实施诈骗。

警方提醒:AI技术的高速发展,到诈骗技术的“推陈出新”,网络的真假让人更难辨别面对这种威胁。大家必须加倍警惕,始终记住“眼见耳听”不一定为实,视频/语音也不一定靠谱。在面对这种新型诈骗手段时,大家需要采取一系列的防范措施,以保护自己和身边的人。

(梅茂莹)